「AIを学ぼう」と思って調べ始めたら、LLM、RAG、MCP、AIエージェント…知らない言葉が一気に出てきて、「結局、何から理解すればいいの?」となった経験はありませんか?

じつは、私がまさにその状態でした(泣)

デザイナーとして日々の業務をこなしながら、「AIのことも知っておかなきゃ」という焦りはある。でも、どこから手をつければいいのかわからない⋯。そんな状態がしばらく続いていたのです。

そこで今回、全体像だけでもざくっと掴んでみようと思い、デザイナー視点でAIの構造を整理してみました。一緒に「AIってそういうことか!」と思えたら嬉しいです。

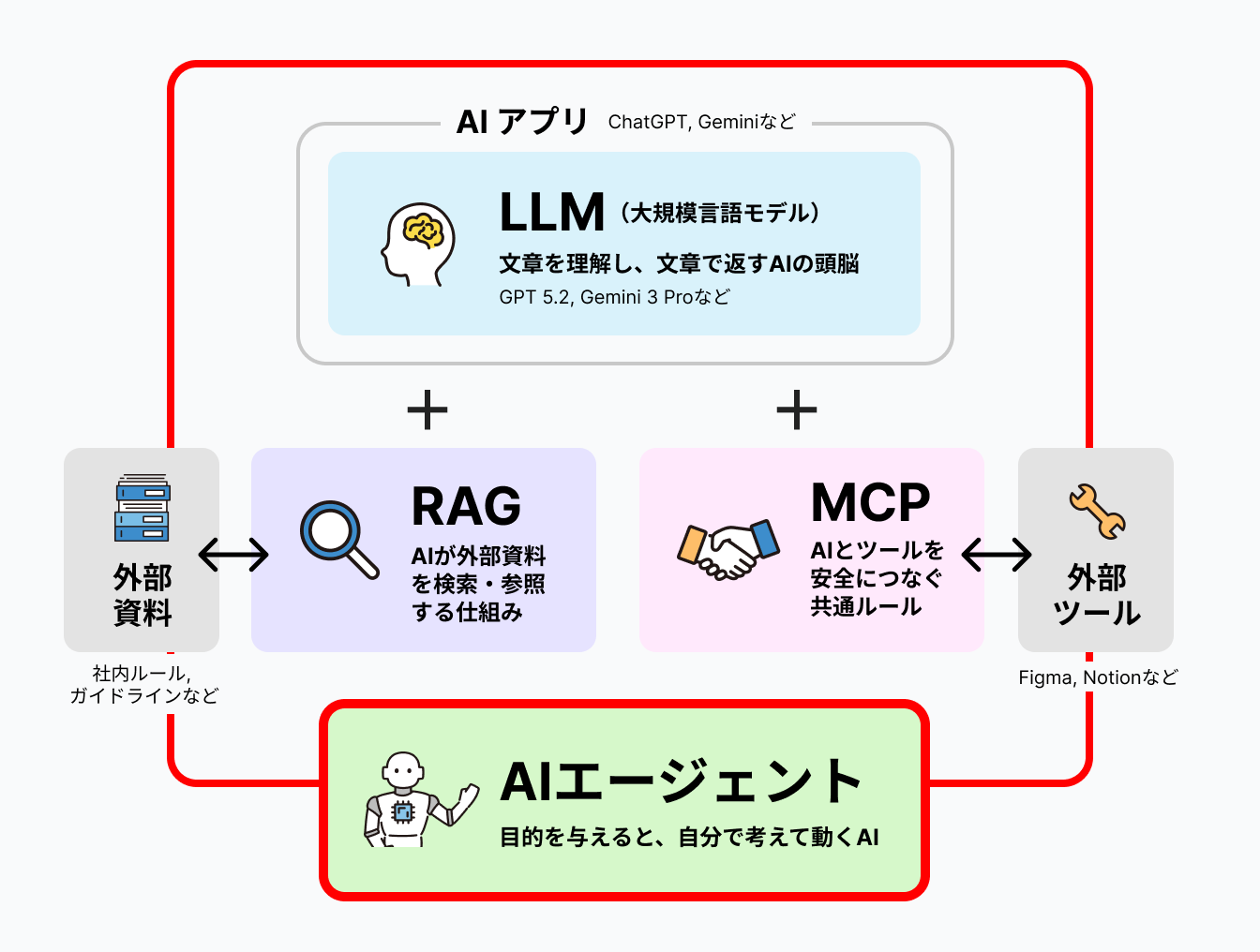

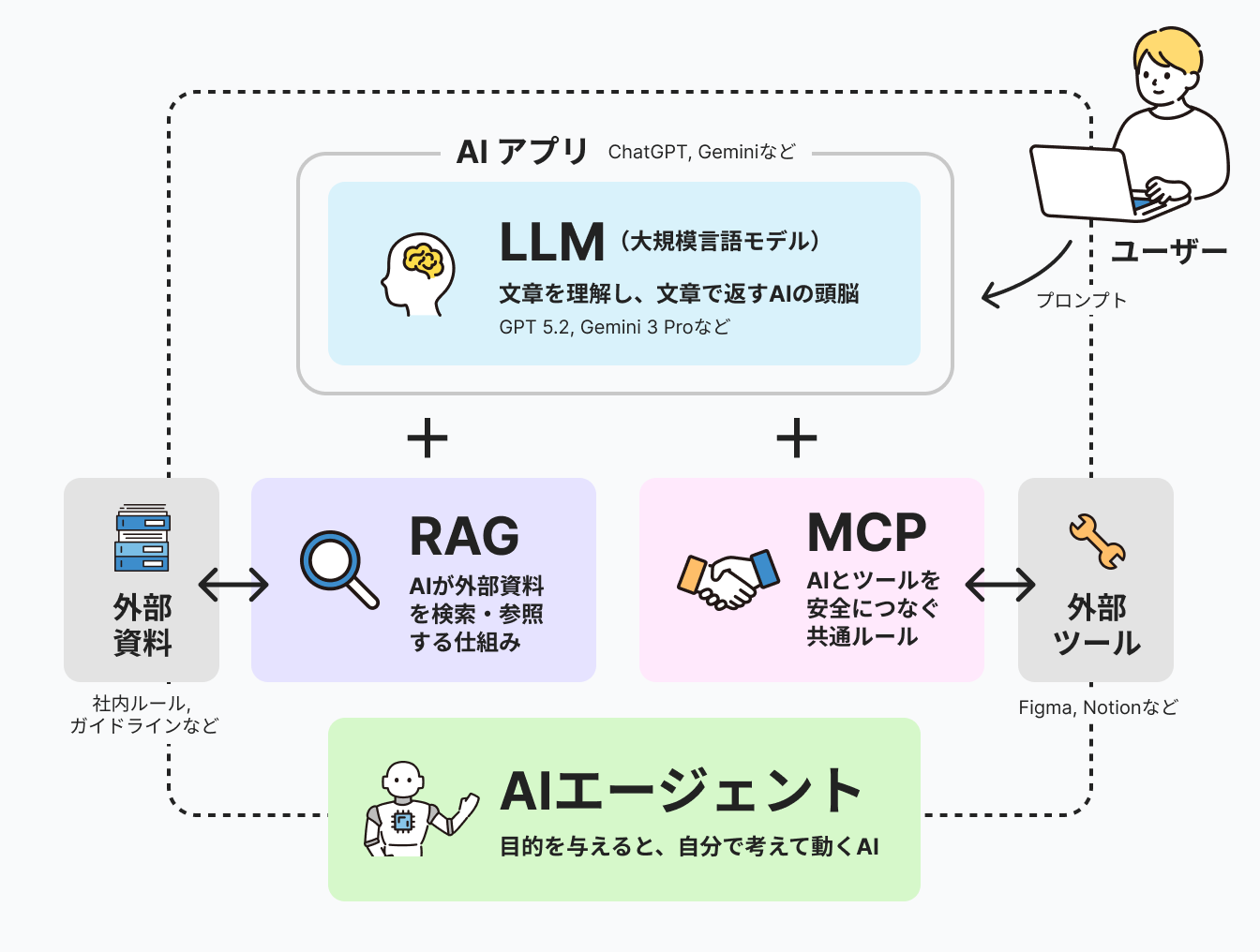

まず結論:AIは「役割ごとの構造」で捉えるとわかりやすい

AIでおさえて置きたいのは、以下の4つです。

- ① LLM(頭脳)

- ② RAG(知識の補強)

- ③ MCP(外部ツールとの接続)

- ④ AIエージェント(自律的に動く仕組み)

この順番で理解していくと、混乱しにくいです。

それでは、ひとつずつ見ていきましょう。

① LLM(Large Language Model):AIの頭脳

まずはLLM。ChatGPTなどの中核にあたる技術で、「文章を理解し、文章で返す」AIの頭脳部分になってきます。

LLM単体でできること

- 文章生成、要約、アイデア出し

- 既存知識をもとにした説明

LLM単体ではできないこと

- 自分から最新情報を取りに行くこと(※)

- 社内資料を勝手に読む

- ファイルやツールを操作する

つまり、「賢いけれど、外の世界を知らない脳」というイメージですね。

だからこそ、後から知識(RAG)や手足(MCP)をつなげる設計が重要になってきます。

※最近は検索機能が組み合わさったAIも増えていますが、それはLLM単体の能力ではなく、外部の仕組みと組み合わせて実現されています。

「生成AI」は、テキスト、画像、音声などの多様なコンテンツを自動生成するAIの総称です。これに対して、LLMはテキスト生成に特化した生成AIだといえます。

<中略>

ChatGPTは、LLMをベースにした対話型のテキスト生成AIアプリケーションのひとつです。具体的にはOpenAIが開発したGPT(Generative Pre-trained Transformer)というLLMを搭載し、「プロンプト」を介してチャット形式でのやりとりを行います。

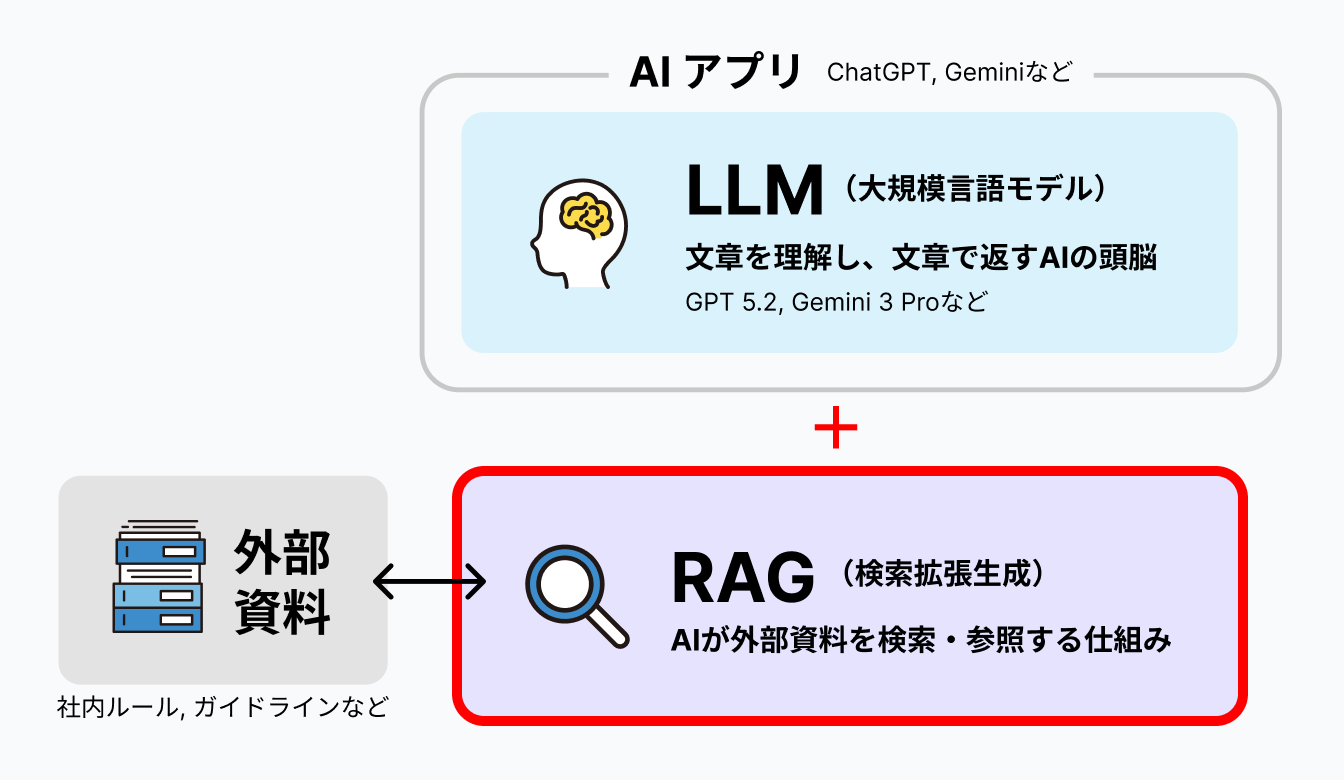

② RAG(Retrieval Augmented Generation):AIに資料を読ませる仕組み

次はRAG。これは、LLMに外部の知識を参照させる仕組みのことです。

デザイン現場での活用例

たとえば、こんな資料をAIに読ませることができるみたいです。

- ブランドガイドライン

- 社内ルール・FAQ

- プロジェクト資料

質問のたびに関連資料を検索し、その内容を踏まえてAIが回答してくれる。「うちのルール前提で答えてくれるAI」を作るための考え方、と理解しました。

これを知ったとき、「デザイナーにとって嬉しい仕組みなのでは?」と思ったんですよね。「このプロジェクトのトンマナって何だっけ?」と聞いたら、ブランドガイドラインを参照して答えてくれる。そんな未来が、もう目の前に来ています。

ChatGPTのファイルアップロード機能は個別ファイルをその場で分析する機能ですが、RAGは大量データを事前に整理・索引化し、質問に応じて最適な情報を検索する仕組みです。

引用元:RAGとは?ChatGPTで社内データを活用する方法・注意点を解説 | 法人向け生成AIチャットのナレフルチャット

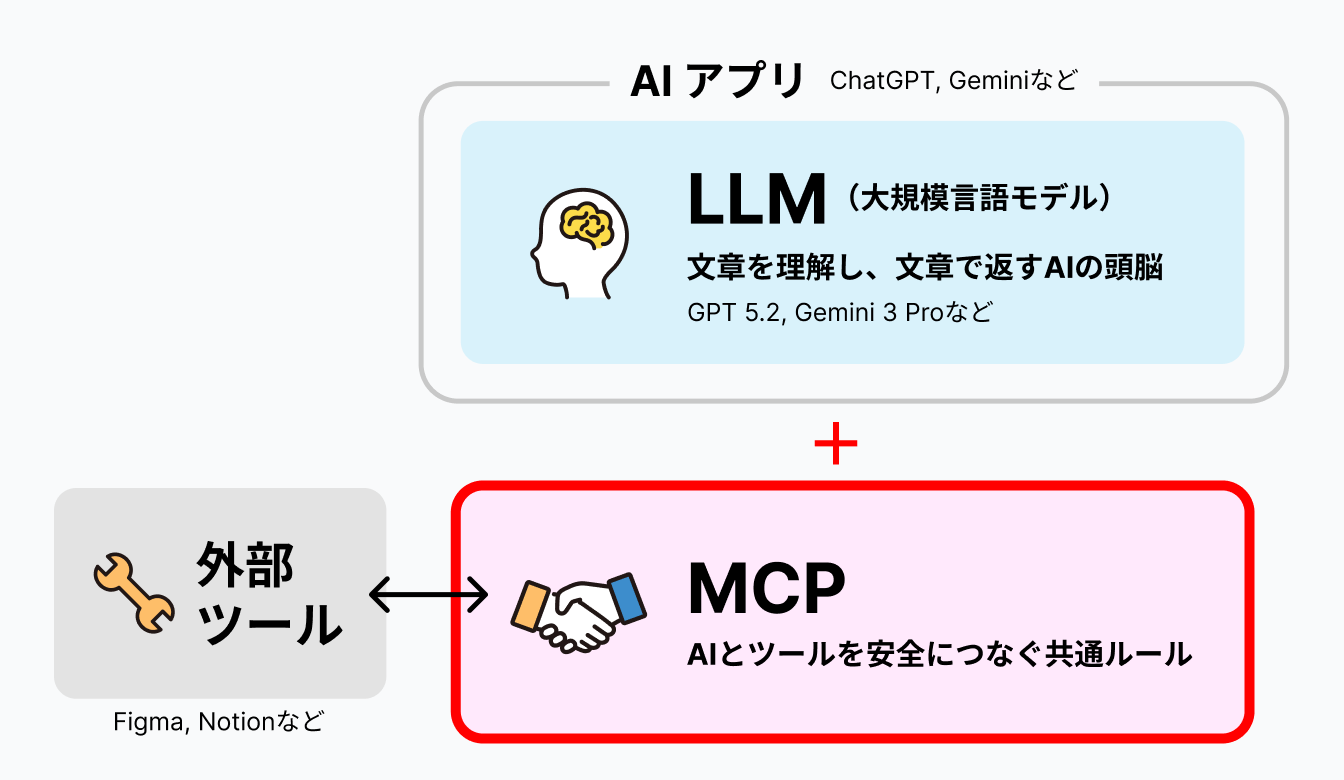

③ MCP(Model Context Protocol):AIに手足を与える接続ルール

3つ目はMCP。これは、AIが外部ツールと安全にやり取りするための共通ルールとのことです。

イメージしやすく言うと

Figma、Notion、Google Drive、Slack…。こうしたツールとAIを「どこまで触っていいか」定義するための設計図、と考えるとわかりやすいかもしれません。

AIに仕事を任せる範囲を決める仕組みとも言えそうですね。

ただ、MCPは比較的新しい規格なので、正直なところ私もまだ完全には理解できていません…。今の段階では「そういうものがあるんだな」くらいの理解で進めています。

デザイナーとして押さえておきたいのは、「AIがツールを操作できるようになる流れがある」という点ではないでしょうか。実装ではなく、構造の話として知っておく、くらいで十分だと思っています。

④ AIエージェント:考えて動くAI

最後はAIエージェント。これは、LLM(頭脳)+RAG(知識)+MCP(手足)を組み合わせて、目的達成のために自律的に動くAIのことです。

デザイナー向けの具体例

たとえば、こんなことができるようになるそうです。

- 競合サイトを調査する

- トーンを考慮した改善案を整理する

- 修正ポイントをリスト化する

これまでの「指示待ちAI」から、「仕事を任せられるAI」への進化段階、という感じでしょうか。

もちろん、すべてを任せるわけではないと思います。でも、「ここまでは任せて、ここからは自分で判断する」という線引きができるようになると、働き方そのものが変わってくるのかもしれませんね。

参考記事:うさぎでもわかる🐰世界初のデザインAIエージェント『Lovart』で創造性を解き放つ!テキストから生まれる無限のデザイン|taku_sid🐰エージェント

→ AIエージェントは、特定の分野に特化して設計されることもあります。Lovartは、ビジュアル表現に特化したAIエージェントの一例です。

参考記事:Adobe、PhotoshopにAIエージェントを導入

→ AdobeでもPhotoshopのアクションパネルにAIエージェントを入れていく話も出てきています。

AI初心者のデザイナーは何から学べばいい?

ここまで読んで、「で、結局何から始めればいいの?」と思った方もいるかもしれません。

調べていく中で見えてきた、おすすめのステップはこちらです。

- ① ChatGPTなどでLLMに慣れる

会話だけでアイデア出しや整理ができる感覚を体験してみる。 - ② RAG(AIに資料を参照させる仕組み)があると知る

ブランドガイドラインや社内資料を前提に、現場寄りの答えができるようになる。 - ③ MCP・AIエージェントは「そういう流れがある」と理解する

将来的にAIがツールを操作し、仕事を任せられるようになる方向性を知っておく。

すべてを一気に学ぶ必要はないんですよね。まずは触ってみて、「これ便利だな」と思えるところから始めてみるのがいいのかもしれません。私もそうしています。

デザイナーにとってAI理解が重要な理由

最後に、調べながら感じたことを少しだけ。

AI時代に求められるのは、「操作できる人」より「設計できる人」なのではないでしょうか。

- どこまでAIに任せるか

- どこを人が判断するか

- どういう体験として提供するか

これって、まさに情報設計・UX・体験設計そのものですよね。

デザイナーだからこそ、AIの「使い方」だけでなく「活かし方」を考えられる。そう思うと、AIを学ぶモチベーションも少し変わってくる気がしています。

まとめ:LLM・RAG・MCP・AIエージェントの全体像

今回、私なりに改めて整理してみたことをまとめると、こうなります。

- LLM:頭脳

- RAG:知識

- MCP:手足

- AIエージェント:自律行動

この4つを全体像として理解できれば、まずは十分なのかなと思っています。

AIは怖いものではなく、構造が見えれば、デザイナーにとって強力な武器になりそうです。「なんとなく難しそう」から「こういう仕組みなのね」に変われたら、それだけで大きな一歩ではないでしょうか。

私もまだまだ勉強中ですが、少しでも参考になれば嬉しいです!

(もし間違えていたらこっそり教えてください⋯!)