生成AI、すごく便利ですよね。でも、AIに質問して返ってきた回答を見て「え、これ本当⋯?」と思ったこと、ありませんか?調べてみたら、実在しない本を紹介されていたり、微妙に事実と違う情報が混ざっていたり。

じつは、これには「ハルシネーション」という名前がついています。AIが幻覚を見ているかのように、存在しない事実を作り出してしまう現象のことなのです。

今回は、その仕組みやリスク、そして私たちデザイナーがどう向き合い、対策していくべきかをまとめました。

AIリテラシーを高めて、より安全に、楽しくAIと付き合っていくためのヒントになれば嬉しいです!

ハルシネーションとは?

ハルシネーション(Hallucination)とは、生成AIが事実に基づかない情報を、あたかも本当のことのように自信満々に答えてしまう現象のことです。

「Hallucination」は日本語で「幻覚」という意味。まるでAIが幻覚を見ているかのように、存在しない事実を作り出してしまうことから、こう呼ばれるようになりました。

ChatGPTやGemini、Claude、Copilotなど、どの生成AIサービスでもこの現象は起こりえます。

ハルシネーションの仕組みとリスク

なぜAIは「もっともらしい嘘」をつくのか【仕組み】

「AIが悪意を持って嘘をついているのかな?」と不安になるかもしれませんが、そうではありません。主な原因は、現在の言語モデルの仕組みそのものにあります。

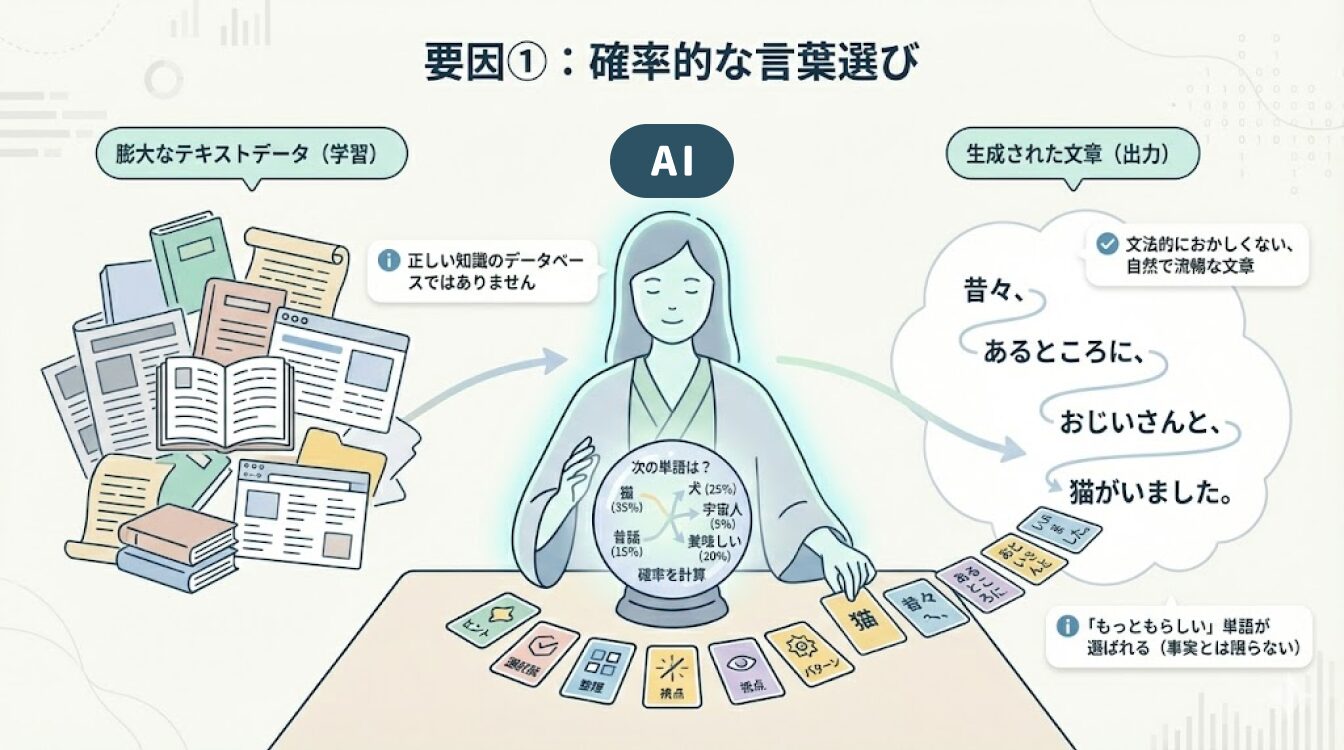

【要因①】確率的な言葉選びをする

ChatGPTやGeminiなどに使用されている大規模言語モデル(LLM)は、「正しい知識のデータベース」を持っているわけではありません。膨大なテキストデータから学習して、「ある単語の次に、どの単語が来る確率が高いか」を計算して文章を繋げているのです。

つまり、AIの目標は「文法的におかしくない、自然で流暢な文章を作ること」。その結果、事実かどうかよりも、文脈として「もっともらしい」単語が選ばれてしまうことがあるんですね。

【要因②】知識の欠落と無理やりな補完

学習データに含まれていない情報や、曖昧な質問に対して、AIは「わかりません」と答えるよりも、学習したパターンを組み合わせて「それっぽい答え」を生成しようとする傾向があります。これが、もっともらしいけど、じつは間違っている回答が生まれる原因です。

昨年12月に公開された経済産業省の「半導体・デジタル産業戦略の今後の方向性(PDF)」にも、“インターネット上の大量のテキストデータを学習し、あらゆる場面で活用されつつある生成AIも、昨今では目前に迫っている「学習データの枯渇」が大きな問題になっている”と取り上げられていました。ハルシネーションが悪化・深刻化していくかもしれませんね。

これらの結果として、文脈としては完璧だけど、中身はデタラメ⋯という「もっともらしい嘘」、ハルシネーションが生まれてしまうのです。

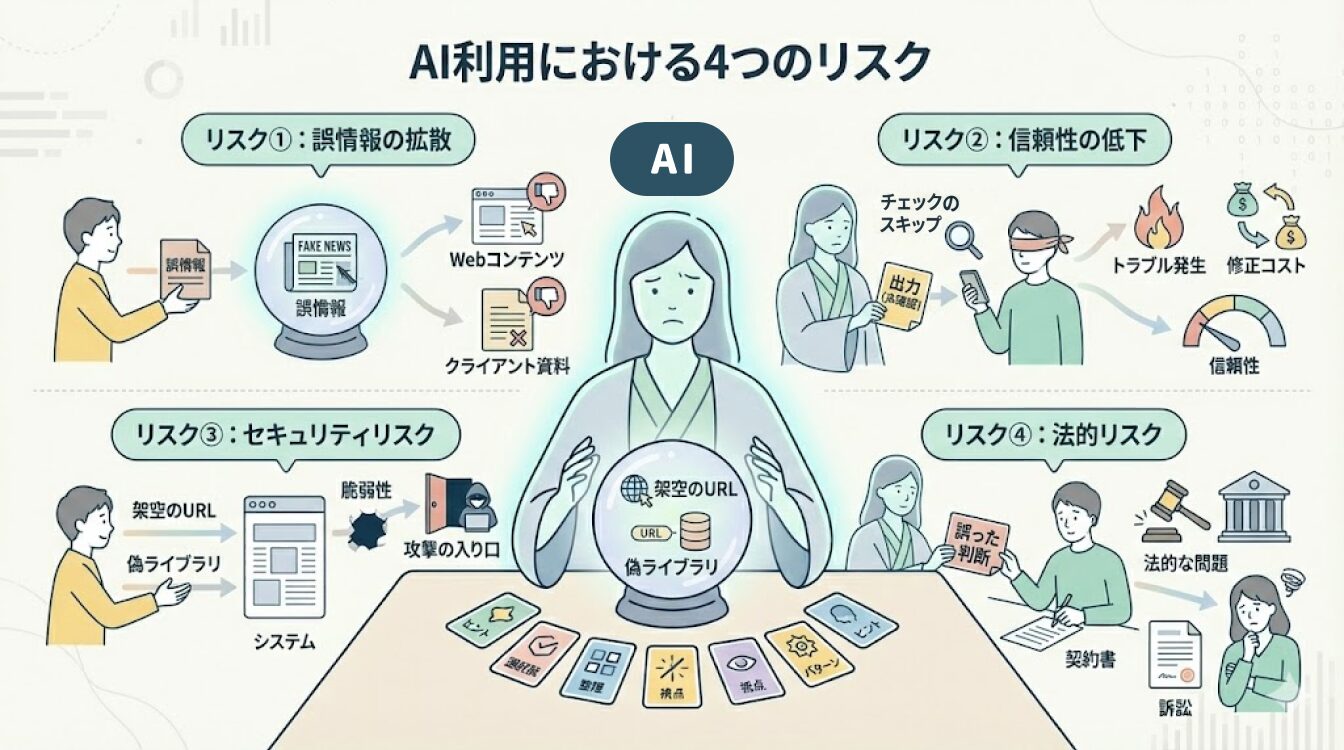

デザイナーが知っておきたいハルシネーションの【リスク】

業務でAIを使うデザイナーにとって、ハルシネーションは次のようなリスクにつながります。

【リスク①】誤情報の拡散

クライアント向け資料やWebコンテンツに誤情報を載せてしまうと、信頼を大きく損なう原因になります。

【リスク②】信頼性の低下

AIの出力を過信し、裏付けを取らずに使うことで、トラブルや修正コストが発生することも。

【リスク③】セキュリティリスク

架空のライブラリやURLを信じてしまい、結果的に脆弱性や攻撃の入り口を作ってしまう可能性があります。

【リスク④】法的リスク

誤った情報に基づく判断が、法的な問題に発展するケースもあります。

実際に起きたトラブル事例

実際にハルシネーションが原因で法的・社会的な問題となった事例があるので、いくつかご紹介します。

事例1:エア・カナダのチャットボット事件

航空会社の公式チャットボットが、公式サイトの規約とは異なる「後日返金可能」という誤った回答をしてしまった事例です。

裁判所は「ボットの発言も企業の責任」と判断し、賠償を命じました。

→ AIの発言が「公式見解」と受け取られる可能性がある、という点がこの事例の怖さです。

事例2:米国弁護士による架空判例の引用

弁護士がChatGPTで作成した書類をそのまま裁判所に提出したところ、

実在しない判例が含まれており、制裁金を科された事例です。

→ 専門家であっても、AIの回答を鵜呑みにすることは大きなリスクになることがわかります。

ハルシネーションへの対策

現在の技術ではハルシネーションを完全にゼロにすることは難しいですが、軽減するための技術や使い方が存在します。

ユーザーとしてできる対策

【対策①】ファクトチェック(裏取り)

- 重要な情報は必ず一次情報(公式サイト・信頼できる文献)で確認する

【対策②】プロンプトの工夫

- 「わからない場合は『わかりません』と答えてください」と指示する

- 「以下の資料のみに基づいて回答してください」と制約を設ける

【対策③】専門分野での慎重な利用

- 医療・法律・金融などでは、必ず専門家の判断を優先する

技術的なアプローチ(RAGとグラウンディング)

RAG(Retrieval-Augmented Generation)

AIに回答させる前に、信頼できる外部データを参照させる技術です。

独自開発の生成AIツール「SeekAI」を全従業員向けに導入し、企業が持つ独自データをRAGに学習させることで、AIによる回答の精度を高めているそうです。

→ プレスリリース:LINEヤフー、RAG技術を活用した独自業務効率化ツール「SeekAI」を全従業員に本格導入。膨大な社内文書データベースから部門ごとに最適な回答を表示し、確認・問い合わせ時間を大幅に削減|LINEヤフー株式会社

グラウンディング(Grounding)

回答の根拠となる出典を明示させる仕組みで、架空情報の生成を防ぎます。

AIが架空のお店をでっち上げるのを防ぐため、必ず自社データベースの最新情報を参照する仕組み(グラウンディング)を徹底し、正確な情報提供を実現したそうです。

→ プレスリリース:食べログ、ChatGPTプラグインの提供を開始

デザイナーが心がけたい3つのスタンス

これまでの内容を踏まえて、デザイナーが日々の業務で心がけたいことを挙げてみました。

1. AIの出力はあくまで「素材」や「下書き」

AIが作った文章、コード、デザイン案は、あくまで「素材」。

それをそのまま完成品として世に出すのではなく、「最終的な品質保証(QA)は人間(私)の仕事」と割り切って捉えるようにしたいです。

2. 「ファクトチェック(裏取り)」を習慣化する

「このライブラリ便利そう!」「この統計データ使えそう!」と思ったら、必ず検索エンジンで一次情報を確認するようにしましょう。

「AIが言ってるから正しい」ではなく、「AIが言ってるけど、本当かな?」という、良い意味での疑いの目を持つことが、自分とクライアントを守ります。

3. 「決定」するのは人間

AIは確率で答えを出しますが、「文脈」や「想い」、そして「倫理観」を判断して決定するのは私たちです。

AIが出してきたもっともらしい答えに流されず、「本当にこれでユーザーに伝わるか?」「クライアントの課題解決になっているか?」を考えるプロセスこそが、これからのデザイナーの価値になるのではないでしょうか。

AIなどの自動化システムにおいて、人間が意思決定や判断、フィードバックを行うプロセスを意図的に組み込む設計思想や仕組みを「ヒューマンインザループ」というそうです。デザイナーとしても、結構大事なキーワードになりそう。

まとめ:AIリテラシーを高めて「良き相棒」にしよう

ハルシネーションは、生成AIの「創造性」の裏返しでもあります。

物語を作ったりアイデア出しをしたりする際には、この「話を膨らませる能力」がとても役に立ちます。ですが、正確な情報を求める際には注意が必要なのです。

「AIは計算機ではなく、言葉巧みな相棒(パートナー)である」と理解して、最終的な事実確認は私たち人間が行うことが大切ですね。

AIをうまく活用しながら、ハルシネーションとも上手に付き合っていきましょう!